Mit Microsoft 365 Copilot bringt Microsoft generative KI direkt in den Unternehmensalltag. Intelligente Funktionen unterstützen bei der täglichen Arbeit – von der Texterstellung, über Meeting-Zusammenfassung bis hin zur Bilderstellung. Doch bei der Nutzung rücken auch Datenschutz, Sicherheit und Governance stärker in den Fokus. Dies liegt besonders darin begründet, dass der KI-Assistent auf mögliche vertrauliche Eingaben des Users und Unternehmensdaten reagiert, um sinnvolle Ergebnisse zu erzeugen. Spätestens mit dem Inkrafttreten des EU AI Act sind Unternehmen aufgefordert, den KI-Einsatz klar zu regeln. (Lesen Sie dazu den unseren Blog-Artikel zum Thema EU AI Act!) Unsere Best Practice-Tipps zeigen Ihnen, wie sich Microsoft 365 Copilot so konfigurieren lässt, dass Produktivität und Compliance Hand in Hand gehen:

Sicher, kontextbezogen, nachvollziehbar: Die Architektur von Microsoft 365 Copilot

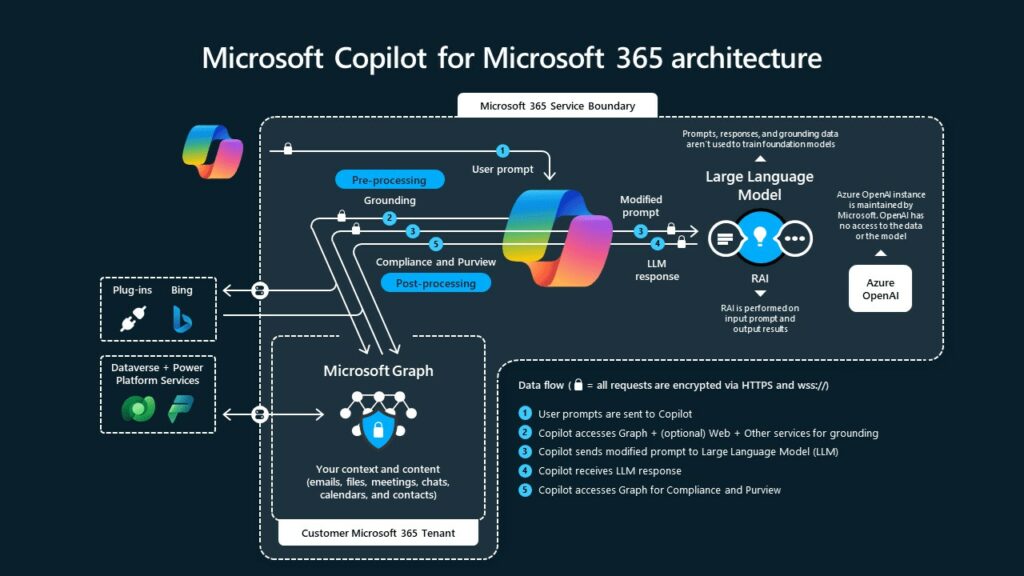

Microsoft 365 Copilot basiert auf einer Architektur, die drei Komponenten kombiniert: Microsoft Graph bindet kontextuelle Unternehmensdaten (E-Mails, Dokumente, Kalender etc.) ein. Zur Verarbeitung wird ein großes Sprachmodell (LLM) genutzt, das in Azure in der jeweiligen Rechenzentrumsregion gehostet wird. Unterstützende Microsoft 365-Dienste wie Bing, Plug-ins oder Power Platform ergänzen die Daten sinnvoll, können sich dabei aber auch außerhalb der Service Boundary befinden.

Daraus ergibt sich folgender Ablauf: Der Prompt eines Nutzers wird zunächst verarbeitet und mit Kontextinformationen aus Microsoft Graph angereichert („Grounding“). Die kontextualisierte Anfrage geht an das LLM, welches daraufhin eine Antwort generiert. Diese Antwort durchläuft abschließend Prüfmechanismen in Microsoft Purview, um Datenschutz- und Compliance-Vorgaben zu erfüllen.

Entscheidend dabei: Alle Datenflüsse sind verschlüsselt. OpenAI hat also keinerlei Zugriff auf die Daten oder Modelle im jeweiligen Microsoft 365 Tenant. Die gesamte Verarbeitung bleibt innerhalb der Microsoft-365-Grenzen.

Fokus auf Compliance: Microsoft Purview & Defender

Für die Einhaltung des EU AI Act spielen Microsoft Purview und Microsoft Defender bei der Einführung und den datenschutzkonformen Einsatz von Microsoft 365 Copilot eine zentrale Rolle:

Defender for Cloud Apps erkennt potenziellen Missbrauch, schützt vor unautorisiertem Zugriff und ermöglicht anomales Nutzungsverhalten zu analysieren, Admins zu benachrichtigen und daraus etwaige Regeln abzuleiten. Besonders die Cloud App Discovery stellt dabei die erste Phase bei der Planung von der KI-Strategie dar, denn mit diesem Tool lassen sich bereits eine erste Nutzung im Unternehmen erkennen.

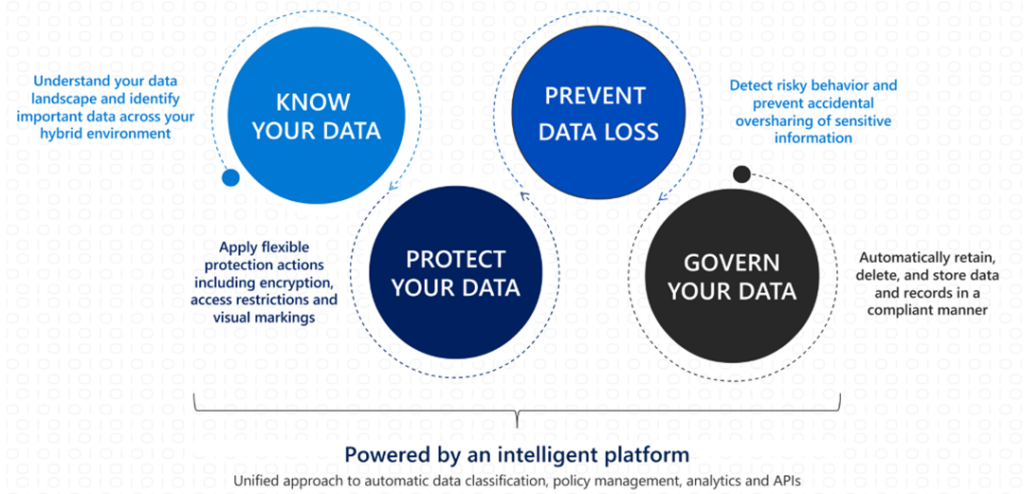

Purview klassifiziert Inhalte automatisch oder manuell mithilfe von Sensitivitätslabels. Data Loss Prevention (DLP) kontrolliert den Datenfluss und stellt sicher, dass Copilot nur auf freigegebene Inhalte zugreift. Zudem kann die Nutzung von Copilot und weiteren Generative AI-Applikationen in Purview erfasst und gesteuert werden. Dies ist von besonderer Relevanz, um den Compliance-Vorgaben gerecht zu werden. Die konkreten Vorgaben des EU AI Act können dabei mittels eines Compliance Assessments im Tenant geprüft und sukzessive umgesetzt werden. Das erspart das manuelle Suchen und Finden von Vorgaben aus der Verordnung.

Von Baseline bis Best-in-Class: Drei mögliche Stufen der Absicherung

Je nach Lizenzmodell und gewünschter Sicherheits- und Compliancestufe lassen sich drei Schutzebenen definieren, mit denen Copilot konfiguriert und eingesetzt werden kann.

Baseline

- Lösungen: Office 365 E3 + Copilot

- Absicherungsmechanismen: Multi-Faktor-Authentifizierung (MFA), Microsoft 365 Audit-Logging

Core

- Lösungen: Microsoft 365 E3 + Copilot + SharePoint Advanced Management

- Absicherungsmechanismen: Conditional Access, Manuelle Sensitivitätslabels, DLP-Richtlinien, erweiterte Zugriffskontrollen für SharePoint

Best-in-Class

- Lösungen: Microsoft 365 E5 + Copilot + SharePoint Advanced Management

- Absicherungsmechanismen: Risiko-basierte Zugangskontrolle, automatische Sensitivitätsklassifizierung, automatisches Entfernen inaktiver Inhalte, erweiterte DLP-Richtlinien, Erkennen riskanter oder nicht konformer KI-Nutzung

Von Beginn an EU AI Act-konform: Vom Rollout bis zum Datenlebenszyklus

Die Implementierung von Copilot sollte aber nicht als einmalige Maßnahme verstanden werden, sondern als Teil eines kontinuierlichen Data Governance Lifecycle:

- Vorbereitung & Rollout: Zunächst müssen die richtigen Lizenzen (E3/E5) ausgewählt werden. Es braucht eine Aktivierung von MFA und Audit-Logging.

- Datenschutz & Klassifikation: Sensitivitätslabels, DLP und Conditional Access sorgen dafür, dass interne Daten geschützt werden und Zugriffe reguliert sind. Je nach Lizenz lässt sich die Klassifikation dabei automatisieren.

- Governance & Zugriffskontrolle: Veraltete Inhalte müssen entfernt und Zugriffsrechte überprüft werden, um Risiken zu minimieren. Steht SharePoint Advanced Management zu Verfügung, lassen sich die Zugriffsrechte darüber verwalten.

- Erkennen von Risiken & Missbrauch: Defender hilft bei der Identifikation verdächtiger Aktivitäten. Eine Lösung, die Anomalien in der Nutzung der KI automatisch registriert, verhindert Missbrauch.

- Audit & Weiterentwicklung: Technologie verändert sich ständig. Daher braucht es ein fortlaufendes Monitoring, sowie regelmäßige Audits und Anpassung an neue Vorgaben.

Der EU AI Act ist die Chance für faire, vertrauenswürdige und verantwortungsvolle KI in Europa. Mit einem durchdachten Setup kann Microsoft 365 Copilot nicht nur die Produktivität im Unternehmen steigern, sondern gleichzeitig die strengen Anforderungen des EU AI Act erfüllen. Sorgen Sie dafür, dass Ihr Copilot-Rollout nicht nur innovativ, sondern auch rechtskonform ist. Wir von Skaylink unterstützen Sie gern bei der Einführung von Microsoft 365 Copilot – von der Lizenzwahl bis zur DLP-Policy. Kontaktieren Sie uns für eine individuelle Beratung durch unsere Experten!

Kontakt

Sie haben Fragen zu M365 Copilot und dem EU AI Act?

Nehmen Sie Kontakt zu uns auf!

Weitere Insights von Skaylink

- Blog

- Blog

- Blog