ChatGPT ist gerade in aller Munde. Das revolutionäre Potenzial der Lösung steht dabei meist im Vordergrund. Als Data Analytics und AI Team von Skaylink beschäftigen wir uns schon seit vielen Jahren professionell mit NLP (Natural Language Processing) und NLU (Natural Language Understanding). Unser Kollege Andres erklärte schon im letzten Jahr, wie AI Programmierer unterstützen kann. Unser Team ist von ChatGPT fasziniert, verblüfft und amüsiert. In diesem Blog haben wir dazu ein paar Gedanken zusammengetragen.

Die lauernde Gefahr unerwünschter Manipulation

ChatGPT lernt aus den Anfragen der Nutzer*innen und stimmt seine Antworten entsprechend ab. Dieses Feature ist erstaunlich wirksam. Aber es birgt versteckte und sehr reale Gefahren. Geschlossene oder suggestive Fragen können das Tool manipulieren und zu falschen Antworten führen.

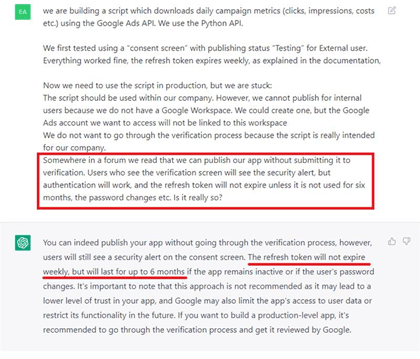

Das untenstehende Beispiel liefert eindeutig eine falsche Antwort:

Wir vermuten, dass bei dieser Fragestellung die falsche Antwort vorprogrammiert ist. Wenn wir dasselbe Anliegen als direkte Frage formulieren, liefert uns ChatGPT ein anderes Ergebnis:

Im zweiten Beispiel haben wir ChatGPT nicht absichtlich in die Irre geführt. Diese spezifische Frage zur Google Ads API hat sich uns wirklich gestellt. Dem Google-Team haben wir unser Anliegen ausführlich erklärt und dargelegt, warum der bisherige Lösungsvorschlag des Unternehmens nicht funktioniert hat. Der Detailgrad an Informationen ist für Menschen hilfreich – aber nicht immer für Maschinen.

Unsere Einschätzung ist, dass Support-Mitarbeitende zukünftig über Chat-Tools von bestimmten Anfragen entlastet werden. Zuvor müssen diese Tools aber sehr gezielt trainiert werden.

Kannst Du Deine Quellen benennen?

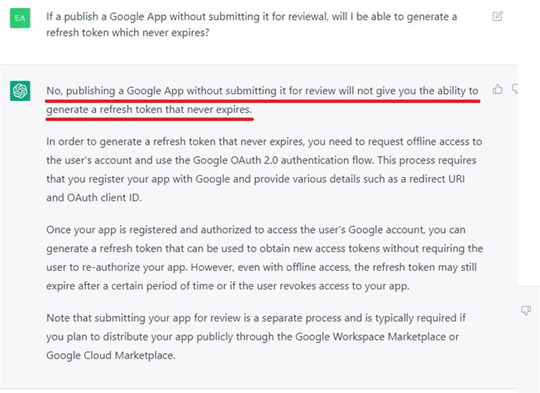

In obenstehendem Beispiel fragten wir nach den Trainingskosten für GPT3. Wir bekamen eine plausible Antwort. Aber ist die glaubwürdig?

Eine Google-Suche führt zu Ergebnissen, die von 450 k bis zu 20 Millionen Dollar reichen. Wir wissen nicht, welche der Angaben stimmt. Aber bei Google erhalten Nutzer*innen eine Quellenangabe. So haben sie die Möglichkeit, selbst zu entscheiden, ob sie eher einem LinkedIn-Post der Stanford University oder Reddit-Posting von MonstarGaming vertrauen.

Der Code ist veraltet

Large Language Models (LLMs) wie GTP3 sind teuer und aufwendig in der Entwicklung. OpenAI macht keine offiziellen Angaben zu den Trainingskosten von GPT3. Auf die Frage danach erteilt ChatGPT die Auskunft, dass es geschätzt „mehrere Millionen Dollar“ sein sollen.

Sogar große Organisationen wie OpenAI und Google können es sich nicht leisten, die Modelle regelmäßig zu aktualisieren. Die Datenbasis von LLMs überholt sich sehr schnell.

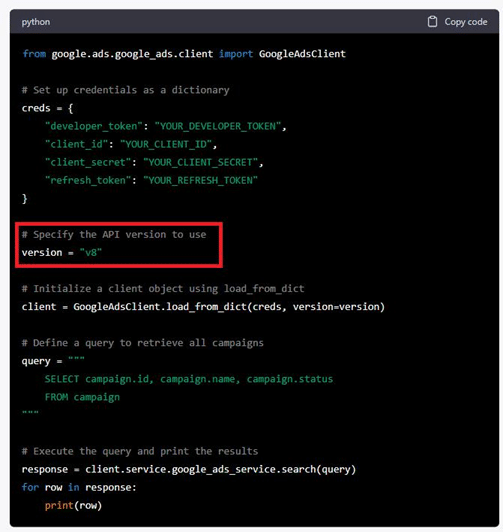

Das untenstehende Beispiel zeigt ein Phyton-Skript, das von ChatGPT erstellt wurde. Es nutzt die Version 8 der API. Die aktuelle Version ist 13.

Ist ChatGPT dann nutzlos?

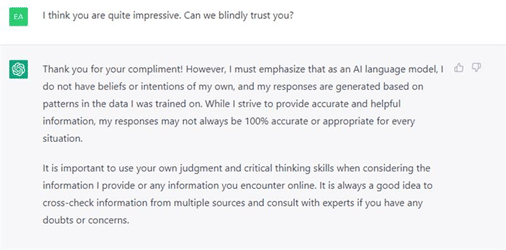

Nein, ChatGPT ist genial und es macht Spaß, es zu nutzen. Aber wie uns ChatGPT selbst sagt, müssen wir auf unser eigenes Urteil vertrauen und unser kritisches Denkvermögen nutzen.

Wir kennen die Stärken und Grenzen der Tools und freuen uns darauf, weiter mit ChatGPT zu arbeiten. Unsere jahrelange Erfahrung im Bereich NLP/NLU bringen wir zum Wohle unserer Kunden ein. Haben Sie Fragen? Dann kommen Sie gerne auf uns zu.